人工智能攻克围棋|AlphaGo的两个“大脑”

谷歌人工智能机器人对战李世石引发全球关注,人工智能也成为了热门话题。Alphabet公司总裁Sergey Brin亲临比赛现场,并在赛后表示“围棋是一种美妙的、充满艺术的游戏。祝贺李世石和DeepMind团队,感谢你们让围棋的魅力通过人与机器的对决完美呈现。”

李世石今天在赛后的记者会上回答记者提问时表示,(谷歌AlphaGo)弱点肯定是存在的,在第一和第二局中就已经看出了它的些许破绽;今天失败的是李世石,而不是人类,AlphaGo绝非神灵般无懈可击。

汇集了AlphaGo背后“最强大脑”的谷歌DeepMind究竟是一个什么样的存在?

DeepMind是由哈萨比斯(Demis Hassabis)、雷格(Shane Legg)与苏莱曼(Mustafa Suleyman)三人于2010年在伦敦创立,宣称“破解智能,用它来让世界变得更好”。2014年,DeepMind正式被谷歌纳入麾下,这也是谷歌截至目前在欧洲地区的最大收购案。

DeepMind在人工智能、深度学习领域的研发实力可以从成立以来发表的各类学术论文中一窥。近六年来,该公司不断在包括Neuron(号称神经科学界的“顶级期刊”)、Nature(全球最权威学术期刊之一)等杂志发表研究成果。尤其是在2014年被谷歌收购后,发表的尖端研究成果数量更是与日俱增。

当然最给DeepMind“长脸”的就是AlphaGo。资料显示,AlphaGo和过去挑战人类的机器们最大的区别在于,它是一款具备“深度学习”功能的机器人,也就是说他不是为了下棋而设计的,是来“学习”下棋的,无时无刻不在模仿人类的思维进行学习。

那么AlphaGo究竟是怎么思考的?

AlphaGo的两个“大脑”

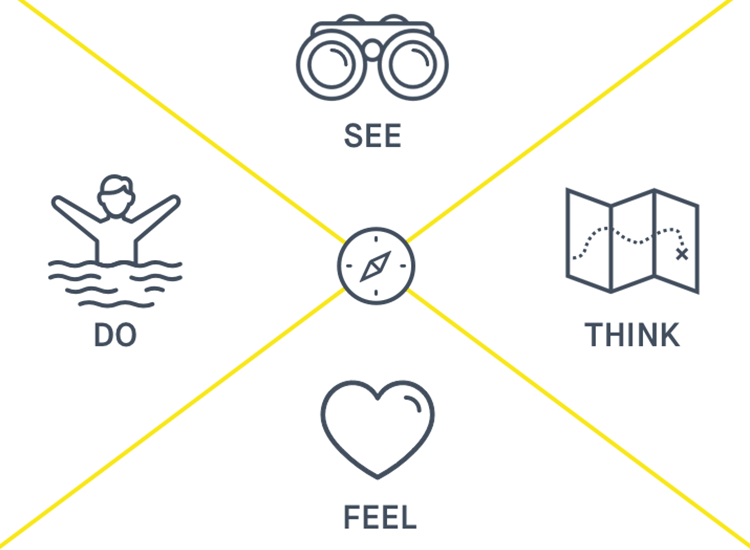

资料显示,AlphaGo下围棋的原理和人类有相似之处,一是判断局部,二是把握全局。DeepMind此前在Nature杂志发表的一篇论文中,也曾有过细节方面的介绍。简而言之就是,AlphaGo总体上由两个不同功能的“大脑”网络组成:策略网络(Policy network)和价值网络(Value network)。

对弈中,AlphaGo的两个“大脑”协同工作。策略网络负责在当前局面下判断“最好的”下一步,可以理解为落子选择器;价值网络负责评估整体盘面的优劣,淘汰掉不值得深入计算的走法,协助前者提高运算效率,可以理解为棋局评估器。然后,两个“大脑”取各自选择的平均值,做出最终的决定。

在这场由人机大战引发的人工智能讨论中,有个术语经常被提起,那就是“蒙特卡洛法”。二战期间冯·诺依曼和乌拉姆两人把他们所从事的研究原子弹的工作,以赌城名蒙特卡洛作为秘密代号来称呼,这就是蒙特卡洛法的来由。

这两位科学家要研究原子弹裂变物质的中子随机扩散规律,当然不能靠天天核爆来采集数据,只能依靠计算机来模拟计算,因此关键就在于如何把这个复杂的物理过程转化为最简单的算术问题。这两位采用了试验数学的一种方法,有效地解决了这个问题,这种方法就是蒙特卡洛法。

例如求一朵云的面积,蒙特卡洛法的思路是先画一个已知面积的方框套住这朵云,然后往上均匀地抛洒黄豆,然后数落入云朵中的黄豆数和落入方框中的黄豆总数,用这个比例乘以方框的面积,就得出了云朵的面积。

可计算机不会撒黄豆啊,于是黄豆就变成了计算机生成的随机数,某个点的横纵坐标都是随机的,然后这个点就是一颗均匀抛洒的黄豆。计算机的简单计算能力是变态的,它可以轻松地生成上万甚至上亿的随机点,而随机点越多,计算出的面积就越精确。

把所有复杂问题都转化为基于随机数和各种分布的简单算术问题,这就是蒙特卡洛法的精髓。

有人感慨机器战胜了人类,还有人忧虑和警惕人工智能的未来。其实并不是机器战胜了人类,而是系统化和科学化的人类智慧战胜了个人智慧,这不是机器的胜利,而是人类智慧的胜利。